C言語で2025年最新サイト対応のウェブスクレイピングを効率よく成功させるための即実践ガイド

- libcurlとlibxml2をセットアップし、動作確認まで7日以内に終わらせる

環境構築が早いほど、エラー発生時も対処しやすく本番導入がスムーズ

- 目標データ量を10,000件以内に限定してテスト運用する

C言語の速度・制御メリットを無駄なく実感でき、不具合切り分けも容易

- CSV出力機能を初期段階で組み込み、必ず1回は書き出しテスト実施

`取得した`だけで終わらない運用イメージが具体化、後工程も安心

- "User-Agent"などリクエストヘッダー設定変更は最初から3パターン以上作成しておく

`最新アンチスクレイピング`対策に柔軟対応できてアクセス遮断リスク減

2025年にC言語でウェブスクレイピングを始める前に知っておきたいこと

[ウェブスクレイピングをC言語でやる話]

二〇二五年にもなれば、ネットから情報を引っ張ってくる方法なんて山ほどある。だけど、C言語で…というのは少し珍しいかもしれない。ちょっと前に自分がやった手順について話してみたい。HTMLをサイトから取ってきて、XPathとか使って必要なデータを抜き出すやり方。最後はCSVにまとめて保存する流れ。うまくいけば思ったより簡単かも、と感じる人もいるだろう。でも、最初はなんだか難しそうに思える部分も多かった気がする。

何で今さらCなの?と疑問に思う人もいるかもしれないね。たしかに他の方法も色々あるけど、特定の理由があって選ぶケースもまだ残っているらしい。例えば速度重視とか、既存プロジェクトとの相性とか、用途による事情はいくつか考えられる。ただし全員向きとは言い切れず、一部の用途や環境限定で役立つこともあるみたいだ。

それと細かい話だけど、「どうやってHTML取るんだっけ?」と途中でつまずいた覚えがある。他にもXPath周りで「あれ、この書き方合ってたかな」と何度か調べ直したことも…。一連の流れ自体はそんなに複雑じゃないけど、小さな工夫やコツがちらほら必要になる場面が出てくる感じだった。

結局、このテーマについて深掘りしてみようと思ったきっかけは「案外できなくもない」くらいの軽い好奇心だった気がする。本当に全部うまく進む保証はなくても、とりあえず挑戦してみたい人には悪くない選択肢になり得そうだ。それでは――まあ、その先へ……

二〇二五年にもなれば、ネットから情報を引っ張ってくる方法なんて山ほどある。だけど、C言語で…というのは少し珍しいかもしれない。ちょっと前に自分がやった手順について話してみたい。HTMLをサイトから取ってきて、XPathとか使って必要なデータを抜き出すやり方。最後はCSVにまとめて保存する流れ。うまくいけば思ったより簡単かも、と感じる人もいるだろう。でも、最初はなんだか難しそうに思える部分も多かった気がする。

何で今さらCなの?と疑問に思う人もいるかもしれないね。たしかに他の方法も色々あるけど、特定の理由があって選ぶケースもまだ残っているらしい。例えば速度重視とか、既存プロジェクトとの相性とか、用途による事情はいくつか考えられる。ただし全員向きとは言い切れず、一部の用途や環境限定で役立つこともあるみたいだ。

それと細かい話だけど、「どうやってHTML取るんだっけ?」と途中でつまずいた覚えがある。他にもXPath周りで「あれ、この書き方合ってたかな」と何度か調べ直したことも…。一連の流れ自体はそんなに複雑じゃないけど、小さな工夫やコツがちらほら必要になる場面が出てくる感じだった。

結局、このテーマについて深掘りしてみようと思ったきっかけは「案外できなくもない」くらいの軽い好奇心だった気がする。本当に全部うまく進む保証はなくても、とりあえず挑戦してみたい人には悪くない選択肢になり得そうだ。それでは――まあ、その先へ……

なぜ今どきC言語でスクレイピング?速度と制御のメリットを解説

C言語って、もう何十年も前から存在してるのに、今でもまあまあ速い方だって話はよく聞く。スクレイピングをCでやるのは珍しい印象だけど、その理由がちょっとずつ分かってきた人もいるんじゃないかな。例えば、ものすごく重たいサイトとか、大量のデータを扱う場合なんかはCだと処理速度が体感で違うとか、そんな声もちらほら。

それとメモリやCPUについても、自分で細かく制御できる場面が多いので無駄が減らせる気がする。もちろん実際にはちょっと設定とか面倒だったりするけど…。なんというか、不具合や遅い部分を探すのも他より楽なところあるみたい。あとは組込み系とか特殊なハードウェアとも結構合わせやすいっぽい。高性能計算機?そういう環境でも時々使われているって聞いたことある。

ただ全部の状況にピッタリというわけではなくて、一部ユーザーによれば特定用途では活躍する感じ、と言った方が近いかな。それぞれメリット・デメリット混在しているし、昔から続いてる技術だからこそ不思議な安心感みたいなのも残ってたり…。

それとメモリやCPUについても、自分で細かく制御できる場面が多いので無駄が減らせる気がする。もちろん実際にはちょっと設定とか面倒だったりするけど…。なんというか、不具合や遅い部分を探すのも他より楽なところあるみたい。あとは組込み系とか特殊なハードウェアとも結構合わせやすいっぽい。高性能計算機?そういう環境でも時々使われているって聞いたことある。

ただ全部の状況にピッタリというわけではなくて、一部ユーザーによれば特定用途では活躍する感じ、と言った方が近いかな。それぞれメリット・デメリット混在しているし、昔から続いてる技術だからこそ不思議な安心感みたいなのも残ってたり…。

Comparison Table:

| 方法 | 概要 | 利点 | 欠点 | 推奨使用ケース |

|---|---|---|---|---|

| C++でのスクレイピング | HTMLから商品情報を抜き出し、配列に格納する方法。 | パフォーマンスが高く、リソース消費が少ない。 | 動的なページやJavaScript処理には不向き。 | データ集めや研究用途。 |

| CSVエクスポート | 商品データをカンマ区切りでCSV形式に保存する手法。 | シンプルで多くのツールと互換性がある。 | 手動設定が必要な場合もあり、間違いやすい。 | 基本的なデータ処理に最適。 |

| ページネーションの処理 | URLを組み立てて複数ページをクロールする方法。 | 全商品の取得が可能になる場合が多い。 | アクセス制限やCAPTCHA対策が必要になることもある。 | 大量の商品情報収集時に有効。 |

| ブラウザ自動操作との併用 | CAPTCHA突破や動的コンテンツへの対応のために自動化ツールを使用するアプローチ。 | 実行容易で高い成功率を得られることが多い。 | セットアップとメンテナンスが複雑になることもある。 | 特定のサイトでのスクレイピングにおいて効果的。 |

| ヘッドレスレンダリングサービス利用 | 他サービス経由でHTMLスナップショットを取得し、その後C言語で処理する手法. | リソース消費を抑えつつ、より広範囲なデータ収集が可能になる場合あり. | コストや外部依存度増加の懸念あり. | 静的またはあまり変化しないサイト向けに適している. |

他のスクレイピング手法と比べてC言語はどうなのか

C言語での開発は、どうやら細かい部分まで自分で調整できるし、速度もかなり出せると言われている。ただ、その分だけ準備とか後からの手入れが結構大変になってくる場面もあるみたい。特に最近のウェブ周りの技術って変わりやすいので、余計にそう感じる人も少なくないようだ。

動的なウェブサイトや、アクセス制限があるページ、それに内容がしょっちゅう変わるような場所からデータを取ろうとすると、場合によってはC言語以外の道具とかサービスを考えることもあるんじゃないかな。例えばBright Dataというところだったか、他にも似たような会社があって…その辺りでは代理サーバー網とか、自動でブラウザ操作する仕組み、それから出来合いのAPIなんかを提供しているケースが目立つ気がする。

こういうサービスを利用すると、多くの場合スクレイピング作業を自動化したり、ちょっと複雑なサイトへの対応もしやすくなる、と聞いたことがある。実際どこまで楽になるかは状況次第だけど、人によっては開発工数がぐっと減った、と話していた記憶が残っている。でも全部のケースで万能というわけでもなさそうなので、そのあたりは試しながら考えてみても良いかもしれないね。

動的なウェブサイトや、アクセス制限があるページ、それに内容がしょっちゅう変わるような場所からデータを取ろうとすると、場合によってはC言語以外の道具とかサービスを考えることもあるんじゃないかな。例えばBright Dataというところだったか、他にも似たような会社があって…その辺りでは代理サーバー網とか、自動でブラウザ操作する仕組み、それから出来合いのAPIなんかを提供しているケースが目立つ気がする。

こういうサービスを利用すると、多くの場合スクレイピング作業を自動化したり、ちょっと複雑なサイトへの対応もしやすくなる、と聞いたことがある。実際どこまで楽になるかは状況次第だけど、人によっては開発工数がぐっと減った、と話していた記憶が残っている。でも全部のケースで万能というわけでもなさそうなので、そのあたりは試しながら考えてみても良いかもしれないね。

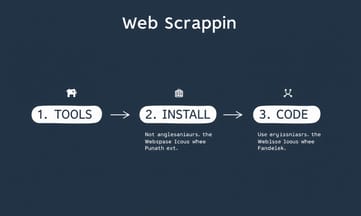

開発環境を整えよう:libcurlとlibxml2のインストール手順

C言語でウェブスクレイピングをやる時、なんだかんだで他の方法も気になる人が少なくないみたい。Cだけに固執せず、用途によっては別の選択肢も検討した方がいいって声もあるとか。ただ、ここでは一応Cを使う前提で話すけど…。

道具集めから始まることが多い。たとえばvcpkgとかapt-getっていうパッケージ管理ツールを使う人がそこそこいるようで、「curl」と「libxml2」というライブラリが必要になりやすい。HTTP通信にはlibcurl、HTML解析ではlibxml2がよく名前に上がるらしい。でも実際のところ、何種類か似たようなものあるし、人によって選ぶもの違ったりするみたい。

LinuxやmacOSなら「sudo apt install libcurl4-openssl-dev libxml2-dev」ってコマンドを打つ場面がちらほら。Windowsだったらvcpkg経由でインストールしてる人も見かけた気がする。「vcpkg install curl libxml2」みたいな感じで。インストール自体は数分から十数分くらいかかった例もあるそう。

開発環境によってリンク設定とかちょっと手間取る場合もあるっぽい。全部サクッと終わればラッキーくらいの感覚でいた方が気楽かもしれない。その辺クリアできたら、「scraper.c」みたいなファイル名でCのコードを書き始める流れになる事例もちょくちょく目にする。

途中で順番変えたり寄り道したりするケースも珍しくないし、ときどき細かな設定ミスとかにも遭遇することありそう。それぞれ状況違うので、一概にこうだとは言えないけど…。

道具集めから始まることが多い。たとえばvcpkgとかapt-getっていうパッケージ管理ツールを使う人がそこそこいるようで、「curl」と「libxml2」というライブラリが必要になりやすい。HTTP通信にはlibcurl、HTML解析ではlibxml2がよく名前に上がるらしい。でも実際のところ、何種類か似たようなものあるし、人によって選ぶもの違ったりするみたい。

LinuxやmacOSなら「sudo apt install libcurl4-openssl-dev libxml2-dev」ってコマンドを打つ場面がちらほら。Windowsだったらvcpkg経由でインストールしてる人も見かけた気がする。「vcpkg install curl libxml2」みたいな感じで。インストール自体は数分から十数分くらいかかった例もあるそう。

開発環境によってリンク設定とかちょっと手間取る場合もあるっぽい。全部サクッと終わればラッキーくらいの感覚でいた方が気楽かもしれない。その辺クリアできたら、「scraper.c」みたいなファイル名でCのコードを書き始める流れになる事例もちょくちょく目にする。

途中で順番変えたり寄り道したりするケースも珍しくないし、ときどき細かな設定ミスとかにも遭遇することありそう。それぞれ状況違うので、一概にこうだとは言えないけど…。

C言語で最初のスクレイパーを作ってみよう

たしか、セットアップを確認するために「Hello World」をまず動かしてみるのが一般的だろう。C言語でWebスクレイピングって話になると、何年も前から変わらずlibcurlやlibxml2なんかを使ってる人が多いように見える。最初は数行だけ書いて、「Web Scraping in C - 2025!」なんて一文を出すコードを書いてみたりする。コンパイル方法も、どこかで見たgccのコマンドを真似して試すことがある。

で、準備が整ったと思ったら、HTTPリクエスト(GET)ができる関数を書く流れになる場合がよくある。libcurl経由でHTMLを取得して、それをメモリ上に蓄えていく感じ。ただ、そのやり方も細部で微妙に違うことがあって、人によってはコールバック関数の書き方やバッファ確保のところで迷ったりするそうだ。再配置(realloc)しながらHTML本文を貯めていくやつ、あれは失敗したとき0返すっぽいけど、本当にそれだけでいいのか少し心配になる時もある。

GetHTMLという名前の関数からHTML文字列が返される。それぞれの環境や状況によっては、「https://example.com」みたいなアドレス指定ですぐ結果が得られるときもあれば、何か引っかかったりエラーになったりする例もありそう。

そのあと、今度はHTML解析へ進む人もいる。libxml2なんか使えばXPath式で要素抽出できるけど、この部分もうまく動作させるまでに時間が結構かかったという声もちょこちょこ聞く。本来ならhtmlReadMemoryとか呼んでメモリ上のデータとしてDOMツリー化してしまうわけだけど、不思議とうまく解釈できないケースにも遭遇することがある模様。

XPath式指定して目的ノード探し出す関数を書く場面では、人によってcontext生成忘れてハマった経験談とかも耳にした気がする。xpathExpr自体も毎回同じ書き方じゃなくて、用途によって微妙に構文変えたりね。

製品情報抜き出したい時にはProduct的な構造体定義することになる場合も多い印象。ただ、このフィールド数や型についてはサイトごとに違ったりして、おそらく約三個とか四個くらい主要項目だけ残す形になりやすい。「MAX_PRODUCTS」みたいな定義値だって、大体百~二百弱くらいまでなら現実的と言われている。もちろん、それ以上収集したケースも稀にはあるようだ。

ECサイトなどから商品情報吸い上げようとすると、一見簡単そうでも細部では意外な落とし穴が潜んでいたりするので、自分なりに試行錯誤しながら進めている人々が多そうな気配だった。

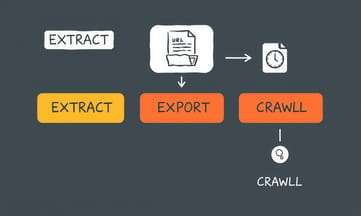

libcurlを使った実践的なHTML取得方法

商品情報を抜き出す方法について、まあだいたいこんな感じのC++コードがあったりする。例えば、HTMLドキュメントから商品リストっぽいliタグを見つけて、それぞれのノードに対して何となくurlや画像、名前、値段なんかを拾って配列に詰め込んでいく流れ。ただ、このあたりは細かい部分でサイトごとに違ってたり、時々うまく取れないこともあるみたい。

CSVへのエクスポートも、それこそ昔からよく見るやり方で、一行目にヘッダーを書いて、そのあと各商品のデータをカンマ区切りで並べる感じ。細かい仕様は人によるけど、大筋は変わらない気がする。

複数ページのクロールになると話がちょっと変わってきて、最近のECサイトだとページネーションが当たり前になってる。ページ番号を増やしながらURLを組み立てて順番にアクセスしていくやり方が多いかな。全部回そうと思うと七十回近く繰り返す場合もあるし、本当にどこまで取るかは状況次第だったりする。

ただ、ここ数年(特に最近)はウェブサイト側も色んな工夫してきていて、例えば短時間にたくさんアクセスすると制限されたりするケースが増えている印象。具体的な数字までは分からないけど、「少し間隔空けたほうが無難」と言われることもよくある。それとは別にプロキシとかIPローテーション使う手法も聞いたことあるけど、それだけで万能というわけでもなさそう。

全体として見ると、「こうすれば絶対大丈夫」みたいなのはあまりなくて、その都度微調整したほうが上手くいきやすいんじゃないかなと思われる。実際には一部ユーザーだけ成功している例もちらほら見かけたし、自動化ツールにも得意・不得意の傾向が出るようなので、一概には言えないところも多いみたいだね。

CSVへのエクスポートも、それこそ昔からよく見るやり方で、一行目にヘッダーを書いて、そのあと各商品のデータをカンマ区切りで並べる感じ。細かい仕様は人によるけど、大筋は変わらない気がする。

複数ページのクロールになると話がちょっと変わってきて、最近のECサイトだとページネーションが当たり前になってる。ページ番号を増やしながらURLを組み立てて順番にアクセスしていくやり方が多いかな。全部回そうと思うと七十回近く繰り返す場合もあるし、本当にどこまで取るかは状況次第だったりする。

ただ、ここ数年(特に最近)はウェブサイト側も色んな工夫してきていて、例えば短時間にたくさんアクセスすると制限されたりするケースが増えている印象。具体的な数字までは分からないけど、「少し間隔空けたほうが無難」と言われることもよくある。それとは別にプロキシとかIPローテーション使う手法も聞いたことあるけど、それだけで万能というわけでもなさそう。

全体として見ると、「こうすれば絶対大丈夫」みたいなのはあまりなくて、その都度微調整したほうが上手くいきやすいんじゃないかなと思われる。実際には一部ユーザーだけ成功している例もちらほら見かけたし、自動化ツールにも得意・不得意の傾向が出るようなので、一概には言えないところも多いみたいだね。

XPathで欲しいデータをピンポイント抽出するコツ

なんだか、User-AgentとかAccept、それにRefererみたいなヘッダーの値を、本物っぽくしておいた方がいいって話がよく聞こえてくる。そういえば、セッションのCookieも…ちゃんとリクエストごとにつないでおかないと、どこかで認証切れたりすることもあるらしい。まあ、こういう細かい設定を忘れてしまう人も少なくないような気がする。

一方で、CAPTCHAというやつ――あれはC言語だけで突破しようとすると、かなり手間取ることもあるみたい。どうしてもブラウザ自動操作とかを絡めたほうが手っ取り早い場面が多いんじゃないかな。詳しくは…いや、自分の記事じゃなくて、ネットで「CAPTCHA解決ツール」と検索すれば色々出てきそうだし、その中でも評判の良さそうなのを参考にする人も結構いる様子。

それでも全部スムーズに進むわけじゃなくて、七十回以上トライしてようやく通る場合や、一度通った後また何か引っかかったりとか…まあ、この辺は運次第とも言える。

一方で、CAPTCHAというやつ――あれはC言語だけで突破しようとすると、かなり手間取ることもあるみたい。どうしてもブラウザ自動操作とかを絡めたほうが手っ取り早い場面が多いんじゃないかな。詳しくは…いや、自分の記事じゃなくて、ネットで「CAPTCHA解決ツール」と検索すれば色々出てきそうだし、その中でも評判の良さそうなのを参考にする人も結構いる様子。

それでも全部スムーズに進むわけじゃなくて、七十回以上トライしてようやく通る場合や、一度通った後また何か引っかかったりとか…まあ、この辺は運次第とも言える。

スクレイピングした商品データをCSVに保存する方法

なんだか最近、ウェブスクレイピングをC言語でやろうとすると、ブラウザみたいな挙動が欲しいって話になることが増えてきた気がする。ヘッダーをいじるだけでも、ちょっとはそれっぽく見せられる場面もあるようだ。「Accept: text/html」みたいな感じで指定しておけば、とりあえずWebサイト側の反応が変わるケースもちらほら。

ただ、今どきのウェブページって、JavaScriptで動いてるものがかなり多い印象。Cだけじゃ正直、その辺の動的な画面までは対応しきれないことが多そう。あれこれ工夫しても限界はある。でも回避策として、HTMLスナップショットを提供するサービスを経由したりとか―つまり一旦他のところでレンダリングさせてから、その結果だけCで処理したり―そんな方法も知られている。全部自分でやるよりは手軽かもしれないけど、それぞれメリットデメリットありそうだ。

最近見聞きする感じでは、「数十倍ぐらい複雑になった」と言われるサイト構造も珍しくなくて、昔ながらのやり方じゃ通用しにくくなってきている雰囲気。とはいえ、細かい状況によって使える手段も違うし、一概には言えない部分が大きいと思う。一部ユーザーは結局他サービス頼みだったりするけど、それでもCで処理したい需要は残っているみたい。完全な解決法というより「その時々に合わせて選択肢を検討」ぐらいの感覚なのかなと思ったりする。

ただ、今どきのウェブページって、JavaScriptで動いてるものがかなり多い印象。Cだけじゃ正直、その辺の動的な画面までは対応しきれないことが多そう。あれこれ工夫しても限界はある。でも回避策として、HTMLスナップショットを提供するサービスを経由したりとか―つまり一旦他のところでレンダリングさせてから、その結果だけCで処理したり―そんな方法も知られている。全部自分でやるよりは手軽かもしれないけど、それぞれメリットデメリットありそうだ。

最近見聞きする感じでは、「数十倍ぐらい複雑になった」と言われるサイト構造も珍しくなくて、昔ながらのやり方じゃ通用しにくくなってきている雰囲気。とはいえ、細かい状況によって使える手段も違うし、一概には言えない部分が大きいと思う。一部ユーザーは結局他サービス頼みだったりするけど、それでもCで処理したい需要は残っているみたい。完全な解決法というより「その時々に合わせて選択肢を検討」ぐらいの感覚なのかなと思ったりする。

2025年のウェブサイトに対応!最新アンチスクレイピング対策

なんだか最近、CとかC++で動作が軽いヘッドレスレンダリングを目指すプロジェクトがちらほら出てきているようだけど、聞いた話ではCの場合は速度やリソースの面から、基本的には変化があまりないサイトや半分くらい静的なページに向いているみたい。全部の用途に万能ってわけでもない。

そういえばウェブスクレイピングをC言語でやる話も、二年先とかになるとちょっと高度な技術っぽくなる傾向があるね。まあ、その分コントロールしやすかったりして、小さいデバイスとか処理速度が気になって仕方ない場面ではかなり役立つこともある、と何人かから聞いたことがある。メモリの消費量とかも他と比べて少なめになることが多いらしい。

たしかlibcurlとかlibxml2みたいなライブラリを組み合わせて使う人もそこそこいて、工夫次第で堅牢にできる…そんな意見もあったかな。ただし、データ集めの方法には注意したほうが良さそうで、一般的なマナーやルールみたいなのは守ったほうが後々困らないとも言われている。

結局のところ、「これ一択」っていうものじゃなくて、それぞれの事情によって選び方も変わる感じ。今後新しいツールや手法も出てくるかもしれないし、この辺は流動的なんじゃないかなぁ…という印象だったりする。

そういえばウェブスクレイピングをC言語でやる話も、二年先とかになるとちょっと高度な技術っぽくなる傾向があるね。まあ、その分コントロールしやすかったりして、小さいデバイスとか処理速度が気になって仕方ない場面ではかなり役立つこともある、と何人かから聞いたことがある。メモリの消費量とかも他と比べて少なめになることが多いらしい。

たしかlibcurlとかlibxml2みたいなライブラリを組み合わせて使う人もそこそこいて、工夫次第で堅牢にできる…そんな意見もあったかな。ただし、データ集めの方法には注意したほうが良さそうで、一般的なマナーやルールみたいなのは守ったほうが後々困らないとも言われている。

結局のところ、「これ一択」っていうものじゃなくて、それぞれの事情によって選び方も変わる感じ。今後新しいツールや手法も出てくるかもしれないし、この辺は流動的なんじゃないかなぁ…という印象だったりする。

JavaScriptが動くサイトでもC言語でスクレイピングできる?

eコマースのページをちょっと調べたり、何かの研究用にデータ集めてたり、あるいは制約が多い環境でスクレイピング処理を埋め込む必要が出てきたり――そういう場面では、C言語がパフォーマンス重視の手段として使われることも少なくないみたい。絶対にこれだけ!という話じゃないけど、開発者の選択肢の一つには入る感じ。

…他にもウェブスクレイピング関連のノウハウとかガイドって色々見かける気がする。例えばScrapyを利用した方法だったり、有名なツールやAPIのまとめみたいなのも探せばたくさん出てきそうだし、「このサイトが良かった」「あっちのサービスも意外と便利」みたいな口コミもちょこちょこ目につく。データセット集めてる人は数え切れないほどいるらしいし、プロキシについて語ってる人もわりといるようで…。Seleniumで自動化してみたって話題とか、PythonとJavaScriptどっちが扱いやすいんだろう?と悩んでる声も時々聞こえてくる。

lxml使ったPythonスクレイピングやExcel経由で情報引っ張るコツなんかは、一部ユーザーから「役立った」と言われているものもあれば、「思ったより難しかった」という感想も混ざっていたり。C#やGoogle Sheetsで試してみた例とか、Amazonベストセラーの商品情報抜き取ろうとして苦労した経験談なんかにもちらほら触れることができそう。

Cloudflare通過に関しては確実な方法があるとは限らなくて、リクエスト頻度を調整する話題なんかも合わせて語られている場合が多い印象。そのへんまで含めて考えると、とにかく色んなアプローチや工夫が紹介され続けている分野なんだろうね。全部網羅するのはたぶん難しいけど、自分なりに合うものを探す人が多いという雰囲気だった。