最近考えてたんだけど、Pythonって、なんか地味だけどすごいよね。Webアプリとか、派手なデータサイエンスのデモとかが目立つけど、実はもっとこう…静かで、でも人の命に関わるような場所で、黙々と仕事してる。

正直、LeetCodeを解くのとか、小さなスクリプトを書くのだけがプログラミングの練習じゃない。本当に力がつくのって、現実世界の問題にぶつかって、それを解決するシステムを、泥臭く作ってるときだと思うんだ。特に、失敗が許されない分野ではね。

医療って、まさにそういう世界。

診断の効率を上げたり、何十億もの個人情報を安全に管理したり。この10年で起きた医療技術のブレークスルーの裏側には、だいたいPythonがいる。この記事で話したいのは、そういうキラキラした話じゃなくて、もっと職人的な、現場の話。7つの、実際のPythonの使われ方。全部に共通してるのは、「まず現実の問題を見つけて、それを解決するために最適な技術を探す」っていう、すごくシンプルな考え方。

重点一句話

Pythonは、完璧な技術を追い求めるより、「目の前の厄介な問題」を解決するための、一番現実的な道具だった。

ケース1:たった数十枚の画像から希少疾患を診断する

まずこれ。遺伝性の病気の中には、5万人に1人とか、それくらいしか患者さんがいないものがある。こういう病気の診断モデルをAIで作ろうとすると、まあデータが足りない。悪夢だよ、本当に。

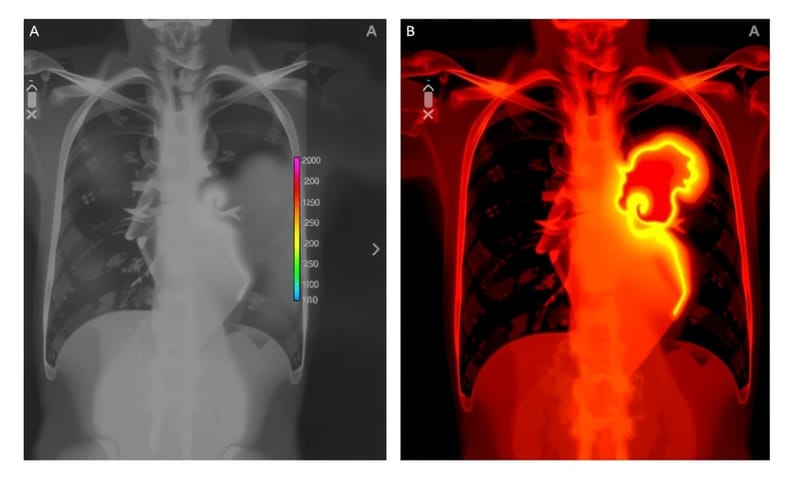

でも、スタンフォード大学の研究者たちは、面白いことをやった。few-shot learning(少数データ学習)っていう手法を使ったんだ。PyTorchを使いつつね。ゼロからモデルを訓練するんじゃなくて、ChestX-ray14みたいな、もっと一般的な、大量のレントゲン画像で既に訓練されたモデルを「転用」したんだ。

ポイントは、ただ転用するだけじゃない。MRI特有の歪みとか、組織がよじれた感じとか、そういう医療画像っぽい「ノイズ」をわざと加えるデータ拡張(data augmentation)を行ったこと。`albumentations`っていうライブラリが、まさにこういう「画像をちょっといじって、擬似的に学習データを増やす」のにすごく便利なんだ。

要するに、AIに「これは猫だよ」って1000枚写真見せる代わりに、「これは虎だけど、まあ、縞模様のついたデカい猫みたいなもんだ」って教える感じ。元の知識があるから、数枚のサンプルでも結構賢くなる。

ケース2:天気予報まで使って、救急外来の待ち時間を予測する

救急外来(ER)がパンクしてるのは、日本も海外も同じ。患者がいつ、どれくらい来るか予測できれば、スタッフの配置とかを最適化できるんだけど、これが難しい。過去のデータだけじゃ、あんまり当てにならないんだよね。

で、カナダのある病院がやったのが、リアルタイムの予測システム。過去の入院記録だけじゃなくて、天気予のAPIとか、地域のイベント情報(例えば、大規模なコンサートとか)までデータソースに加えた。Pythonの`pandas`でぐちゃぐちゃなCSVを整理して、Facebookが開発した`prophet`っていう時系列予測ライブラリでモデルを訓練。で、その予測結果を1時間ごとにWebダッシュボードに流し込む。Flaskでサクッと作ったらしい。

これ、最新の深層学習とかじゃなくて、すごく地道なエンジニアリング。でも、現場にとってはこっちのほうがよっぽど役に立つ。大事なのは、綺麗なデータと、その分野の知識(ドメイン知識)、そしてちゃんと考えられた設計だってことだね。

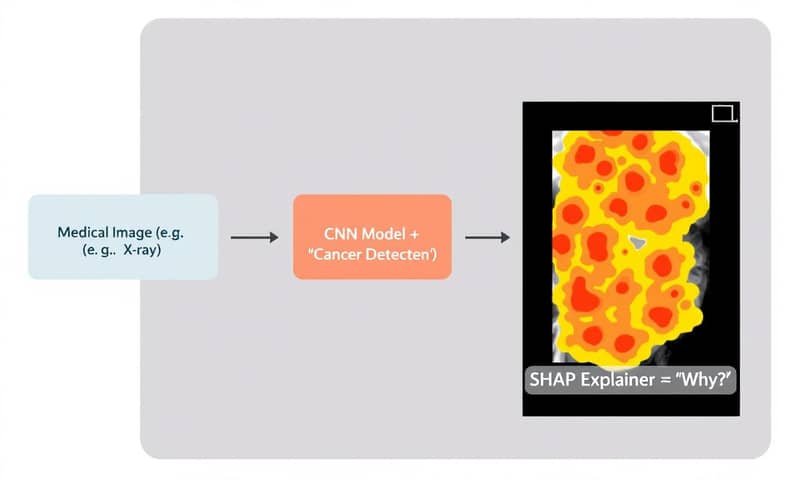

ケース3:「AIの判断理由」を説明できなければ、現場では使えない

これは本当にそう思う。医者は「AIが癌だと言ってます」って言われても、信用しない。「なぜそう判断したのか?」が分からないと。ブラックボックスはダメ、絶対。

イギリスのチームがやったのは、診断モデル自体は普通のCNNなんだけど、その周りをSHAP(SHapley Additive exPlanations)っていうライブラリで包んだこと。SHAPは、モデルが画像の「どの部分を見て」その結論に至ったのかを可視化してくれる。ちょうど上の図みたいな感じだね。

これ、毎回リアルタイムで計算すると重いから、あらかじめ計算しておいたSHAP値をオフラインで用意しといて、FastAPIで必要なときにだけサッと取り出せるようにしたらしい。うまいやり方だ。

医療の世界では、精度そのものよりも「透明性」が重視される。これはマジで大事。倫理委員会を通らないからね、説明できないモデルは。

いくつかの事例を比べてみると…

こうやって見ると、解決したい課題によって使う技術もアプローチも全然違うのが面白い。ちょっとまとめてみようか。

| 解決したい課題 | キーになった技術 | 個人的な感想・ポイント |

|---|---|---|

| 救急外来の混雑をなんとかしたい | pandas, prophet (時系列予測) |

最新AIじゃなくてもOK。天気とかイベント情報とか、色々なデータを組み合わせる発想がすごい。地道だけど効果は絶大だと思う。 |

| AIの診断結果を医者に信用してほしい | SHAP (説明可能AI) |

これからの医療AIの必須科目だね。精度99%でも「理由は不明です」じゃ話にならない。透明性こそが信頼につながる。 |

| 退屈な医療コーディングを自動化したい | scikit-multilearn, LightGBM |

一番、費用対効果が分かりやすい例かも。作業時間が3分の1になったとか…。こういう「誰かの面倒な仕事」をなくすのが、Pythonの一番得意なことかもしれない。 |

ケース4:面倒な医療コーディングを自動化する

病院の記録には、ICD-10っていう国際的な診断コードを割り振る作業がある。医者の書いたメモを読んで、「この症状ならこのコード」ってやつ。これ、すごい手間がかかるし、間違いも多い。

アメリカのあるヘルスケア系スタートアップは、これを自動化するNLP(自然言語処理)パイプラインをPythonで構築した。医師のメモを読み込ませると、可能性の高いコードをトップ3まで提案してくれるシステム。`spaCy`とか`transformers`みたいなライブラリを使いつつ、`scikit-multilearn`で複数のコードを同時に分類できるようにして。機械学習だけじゃ対応しきれないエッジケースは、カスタムのルールで補う。このハイブリッドな感じが、すごく実践的。

結果、コーダーの処理件数が1時間あたり12件から40件以上に増えたらしい。生産性が3倍以上。すごいよね。

ケース5:個人情報を守りながらAIを活用する [HIPAA]という壁

クールな機械学習モデルを作るのと、それを規制の厳しい環境で「合法的に」運用するのは、全く別の話。特にアメリカでは、HIPAA(医療保険の相互運用性と説明責任に関する法律)っていう、患者の個人情報保護に関するめちゃくちゃ厳しい法律がある。

ある大手病院の内部ツールでは、Pythonを使ってテキストや画像から自動で個人識別情報(PII)を検出する仕組みを作った。例えば、正規表現(`re`モジュール)で社会保障番号っぽい数列を探したり。で、少しでも怪しいとフラグが立ったデータは、LLMとかのAIモデルに渡す前に、必ず人間がレビューする。このレビューのパイプラインはDjangoとCeleryで作られてたらしい。

これ、日本だと厚労省が出してる「医療情報システムの安全管理に関するガイドライン」とかが近い立ち位置かな。考え方は同じで、患者さんのデータを無加工でポンと外部のAIに投げちゃダメだよ、ってこと。コンプライアンスって、開発を邪魔する壁じゃなくて、システム設計に組み込むべき制約の一つなんだよね。

ケース6:画像とメモ、両方で医療データを検索する

病院には、CT、MRI、超音波…何百万もの画像ファイルが、いろんな部署のいろんな機器に散らばってる。これを「右上肺野の結節影」みたいなキーワードで探すのは、ほぼ不可能だった。

ドイツのAI研究所が作ったのは、マルチモーダルな検索システム。OpenAIが開発したCLIPっていうモデルを使って、画像データと、放射線技師が書いたレポートのテキスト、両方を同じベクトル空間に埋め込む。…ちょっと難しいかな。要するに、画像と単語を「同じ言語」に翻訳する感じ。だから、「上脛骨付近の骨折」っていうテキストで検索すると、関係する画像が、CTとかMRIとかの種類を問わず見つかるようになった。

これ、もう研究論文だけの話じゃなくて、実際に医者が日常的にデータを探索する方法を変えつつある。

ケース7:パンデミック下で、72時間で感染追跡システムを立ち上げる

COVID-19のピーク時、病院はリアルタイムの院内感染状況が分からず、手探り状態だった。

そんな中、あるエンジニアチームがPythonで、たった72時間で地理空間ダッシュボードを構築した。患者のバイタルデータ、位置情報、検査結果を`Kafka`でストリーミングして、Pythonでリアルタイムに処理。そして`folium`っていうライブラリで地図上にマッピングした。

緊急時には、完璧なシステムより、「速くて、そこそこ使える」システムの方が価値がある。まさにその典型例。Pythonのこういう「とりあえず形にする」スピード感は、本当に武器になる。

まとめというか、思ったこと

こうしていくつかの事例を見ていくと、結局、使われているライブラリや構文そのものがすごいわけじゃないんだよね。まあ、それもすごいんだけど。

一番大事なのは、「問題解決が先」っていうマインドセットだと思う。これらは全部、誰かの「これが解決したら、すごく助かるのに」っていう切実な問いへの答えだった。

だから、もし次に何か作りたいなと思ったら、よくあるToDoアプリとかじゃなくて、ちょっと周りを見渡して、

- 身の回りの医療現場で、何が壊れているんだろう?

- 誰かが、スクリプトで自動化できるような作業に、無駄な時間を費やしてないか?

- Pythonが、時間やお金、あるいは人の命を救える場所はどこだろう?

…なんてことを考えてみるのがいいのかもしれない。それが、一番速く成長する方法だし、記憶に残るものを作る方法なんだと思う。

あなたに質問です。

もし今日紹介したようなツールを自由に使えるとしたら、あなたの仕事や生活の中にある、どんな「小さな、でも面倒な問題」を最初に解決してみたいですか?よかったら、下で教えてください。