まずはこのステップを実行してみて - Pythonの力でロボット開発を効率よく実用化するコツ

- 週に2回、Pythonのセンサー処理やAIライブラリを使ったコード例を動かす

実データに触れる頻度が増え、現場でのエラー対応力が養われる

- 3種類以上の異なるセンサー情報を組み合わせて小規模な自律動作テストを作成

複雑な状況でも安定して判断できるロボット設計につながりやすい

- シミュレーターと実機で同じアルゴリズム検証、7日以内に差分チェック

仮想環境特有の落とし穴や現場ギャップを早期発見しやすくなる

- `壊れても止まらない`設計として障害検知コードを週1でアップデート

`もしも`への備えが日常になり、不意な停止リスクが減る

1. 静かな主役、Pythonが裏で支えるロボット革命?

多くの人は、Pythonがこっそりとロボット工学でずっと貢献している事実に、あまり目を向けないんだよね。まあ、仕方ないか。でも、それってちょっと不思議というか…何でみんな気づかないんだろう。

> 優秀なロボティクスエンジニアってさ、ただ機械を形にするだけじゃなくて「動き」に知性や感覚を吹き込もうとしてる。それなのに、その根底を支えてるプログラミング言語が何なのか尋ねられると、多分ほとんどの人はPythonだとはすぐ出てこない、たぶん。でも…やっぱりPythonなんだよね、不思議。

ロボット工学の話題となると、どうしてもヒューマノイド型ロボットがバク転した!とか、踊る犬型ロボットが人気とか…そういう派手な話ばっかり目立つ気がする。うーん、自分でもYouTubeで変な動画見て脱線しちゃったことあるし、本筋からそれやすいけど——まあ戻ろう。でも、本当のところ、それらの進化を静かに裏側で支えているのは間違いなくPythonなんだよね。実際には、この言語のおかげで生まれてる可能性もけっこう大きい。長くなるけどちょっと語らせて。本稿では単なるライブラリ名リストとか流行語ぽいトピックだけじゃなくて、その奥に潜むものにも触れたいと思っている(いや、むしろ浅いまとめなら飽きたし)。

> 優秀なロボティクスエンジニアってさ、ただ機械を形にするだけじゃなくて「動き」に知性や感覚を吹き込もうとしてる。それなのに、その根底を支えてるプログラミング言語が何なのか尋ねられると、多分ほとんどの人はPythonだとはすぐ出てこない、たぶん。でも…やっぱりPythonなんだよね、不思議。

ロボット工学の話題となると、どうしてもヒューマノイド型ロボットがバク転した!とか、踊る犬型ロボットが人気とか…そういう派手な話ばっかり目立つ気がする。うーん、自分でもYouTubeで変な動画見て脱線しちゃったことあるし、本筋からそれやすいけど——まあ戻ろう。でも、本当のところ、それらの進化を静かに裏側で支えているのは間違いなくPythonなんだよね。実際には、この言語のおかげで生まれてる可能性もけっこう大きい。長くなるけどちょっと語らせて。本稿では単なるライブラリ名リストとか流行語ぽいトピックだけじゃなくて、その奥に潜むものにも触れたいと思っている(いや、むしろ浅いまとめなら飽きたし)。

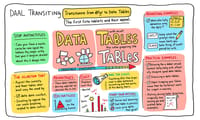

2. センサ融合のカオス、リアルタイムって面倒くさい

これが、ロボティクスエンジニアにとって妙に実用的で、しかも少しだけ尖った感じの**7つのPythonワークフロー**なんだよね。ま、たぶん個人開発者でも企業のR&D部門でも——いや、本当に場所は問わず——現場で直面する課題解決にちゃっかり使われてたりする。…ああ、「また課題ベース?」って思うけど、結局そこから始めるしかない気がしてさ。今回も例のごとくコードを交えながら、それぞれどう組み上げていくかをぼんやり伝えてみようかな、と。でもまあ、正直途中で脱線したらごめんね。じゃ、とりあえず進もう👇

## 1. 頭が痛くならないリアルタイムセンサーフュージョン

**🧠 課題:** ロボットってさ、「目」や「耳」みたいなもの——LIDARだったりIMUだったりGPSとか超音波センサーまで積むこと多いじゃない?でもそれぞれノイズ含んだ出力をリアルタイムでひとつにまとめる“脳”が足りない瞬間がある。うーん、この辺いつもモヤモヤしてしまう。

**💡 Pythonによる解決策:** `filterpy` を活用すればリアルタイムカルマンフィルターも割と簡単に書けちゃうし、それに加えて `rosbag` や `ros2bag` 使えば同期したセンサーデータストリームを再生できてデバッグ時にも地味に助かる。不意に変な動作起きても「あれ…自分ミスった?」ってなるし。

from filterpy.kalman import KalmanFilter

kf = KalmanFilter(dim_x=4, dim_z=2)

kf.x = np.array([0., 0., 0., 0.]) # 初期状態

kf.F = np.array([[1, 1, 0, 0], # 状態遷移行列

[0, 1, 0, 0],

[0, 0, 1, 1],

[0, 0, 0, 1]])

# HやRやQやP行列ももちろん追加しなきゃ…(ここ毎回忘れる)

for z in measurements: # GPS測定値とかね

kf.predict()

kf.update(z)

> _🧠 F_act:_ 実はNASAの火星探査車でもIMUとステレオビジョンデータ統合にはカルマンフィルター技術が応用された事例あるみたい。へぇ…。

**使用ライブラリ:** `filterpy`, `rosbag`, `numpy`, `scipy`

## 1. 頭が痛くならないリアルタイムセンサーフュージョン

**🧠 課題:** ロボットってさ、「目」や「耳」みたいなもの——LIDARだったりIMUだったりGPSとか超音波センサーまで積むこと多いじゃない?でもそれぞれノイズ含んだ出力をリアルタイムでひとつにまとめる“脳”が足りない瞬間がある。うーん、この辺いつもモヤモヤしてしまう。

**💡 Pythonによる解決策:** `filterpy` を活用すればリアルタイムカルマンフィルターも割と簡単に書けちゃうし、それに加えて `rosbag` や `ros2bag` 使えば同期したセンサーデータストリームを再生できてデバッグ時にも地味に助かる。不意に変な動作起きても「あれ…自分ミスった?」ってなるし。

from filterpy.kalman import KalmanFilter

kf = KalmanFilter(dim_x=4, dim_z=2)

kf.x = np.array([0., 0., 0., 0.]) # 初期状態

kf.F = np.array([[1, 1, 0, 0], # 状態遷移行列

[0, 1, 0, 0],

[0, 0, 1, 1],

[0, 0, 0, 1]])

# HやRやQやP行列ももちろん追加しなきゃ…(ここ毎回忘れる)

for z in measurements: # GPS測定値とかね

kf.predict()

kf.update(z)

> _🧠 F_act:_ 実はNASAの火星探査車でもIMUとステレオビジョンデータ統合にはカルマンフィルター技術が応用された事例あるみたい。へぇ…。

**使用ライブラリ:** `filterpy`, `rosbag`, `numpy`, `scipy`

3. シミュレーションから現実へ落とし穴多すぎ問題

Sim-to-Real Transfer Using PyBullet

**🧠 問題:** ロボットを現場で訓練するって、どうしてもお金かかるし、危険だって話はよく聞く。正直やりたくない日もあるんだよね。ああ、まあシミュレーションが役立つこともあるけど…実際に学習済みのポリシーを本物のロボットに持ち込むとき、なんだか壁にぶつかったような感覚になる。全部うまくいくと思ったら案外そうでもなくて、現実世界と仮想空間のギャップがやっぱり厄介なんじゃないかな、と悩む瞬間もある。

**💡 Pythonによる解決策:** `PyBullet` でロボットの物理挙動を擬似的に再現できる、それだけでも気持ちは少しラクになるけど、本当にそれだけ? えっと、その上でドメインランダム化という手法と `gym` の環境を組み合わせて強化学習ポリシーの汎用性――つまり色んな状況で使える幅広さ――を狙う方法がけっこう主流になっている気がする。でも途中で「あれ、自分何してたっけ」と思ってコーヒー淹れたり…。ま、戻ろう。本筋としてはそんな感じ。

> _🧪 F_act: _OpenAI はルービックキューブ操作タスク(ロボットハンド)で現実対応へ向けたドメインランダム化活用事例が知られている。ただ自分の場合はそこまで突き詰めたことないんだけど…。_

**使用ライブラリ:** `pybullet`, `gym`, `numpy`, `tensorflow` または `torch`

## 3. MicroPython + OpenMV によるエッジベースコンピュータビジョン

**🧠 問題:** 映像データって常時クラウド送信しなくても本当は困らなかったりする。オンボード処理なら速いしコスト面も助かるし、それにプライバシー配慮にも一応なる。でも設計とか運用していると「あれ、この方式思ったよりクセ強い?」と思い始めたりして…いや、大抵の場合メリット大きいんだけど、一方では独特な難所も顔を出す気配があるので油断できないんだよなあ。

**🧠 問題:** ロボットを現場で訓練するって、どうしてもお金かかるし、危険だって話はよく聞く。正直やりたくない日もあるんだよね。ああ、まあシミュレーションが役立つこともあるけど…実際に学習済みのポリシーを本物のロボットに持ち込むとき、なんだか壁にぶつかったような感覚になる。全部うまくいくと思ったら案外そうでもなくて、現実世界と仮想空間のギャップがやっぱり厄介なんじゃないかな、と悩む瞬間もある。

**💡 Pythonによる解決策:** `PyBullet` でロボットの物理挙動を擬似的に再現できる、それだけでも気持ちは少しラクになるけど、本当にそれだけ? えっと、その上でドメインランダム化という手法と `gym` の環境を組み合わせて強化学習ポリシーの汎用性――つまり色んな状況で使える幅広さ――を狙う方法がけっこう主流になっている気がする。でも途中で「あれ、自分何してたっけ」と思ってコーヒー淹れたり…。ま、戻ろう。本筋としてはそんな感じ。

go

import pybullet as p

import pybullet_envs

python

env = gym.make("AntBulletEnv-v0")

observation = env.reset()

for _ in range(1000):

action = env.action_space.sample()

observation, reward, done, info = env.step(action)

if done:

observation = env.reset()> _🧪 F_act: _OpenAI はルービックキューブ操作タスク(ロボットハンド)で現実対応へ向けたドメインランダム化活用事例が知られている。ただ自分の場合はそこまで突き詰めたことないんだけど…。_

**使用ライブラリ:** `pybullet`, `gym`, `numpy`, `tensorflow` または `torch`

## 3. MicroPython + OpenMV によるエッジベースコンピュータビジョン

**🧠 問題:** 映像データって常時クラウド送信しなくても本当は困らなかったりする。オンボード処理なら速いしコスト面も助かるし、それにプライバシー配慮にも一応なる。でも設計とか運用していると「あれ、この方式思ったよりクセ強い?」と思い始めたりして…いや、大抵の場合メリット大きいんだけど、一方では独特な難所も顔を出す気配があるので油断できないんだよなあ。

4. 小さなカメラで賢くなる?エッジAIの意外な実力

💡 Pythonによるソリューション――いや、何を書いているんだろう。えっと、OpenMVカメラにMicroPythonを組み合わせれば、ライン追従とか色検出みたいなやつ…すごく単純なビジョン系のタスクが、デバイス上だけでふつうにできる。そんな話だったよね。

sensor.reset()

sensor.set_pixformat(sensor.RGB565)

sensor.set_framesize(sensor.QVGA)

sensor.skip_frames(time = 2000)

while(True):

img = sensor.snapshot()

blobs = img.find_blobs([(30, 100, 15, 127, 15, 127)]) # …赤色かも。

for blob in blobs:

img.draw_rectangle(blob.rect())

なんというか、このOpenMVボードってさ、<100msのレイテンシーでビジョンタスク実行できちゃうらしい。ミニドローンにも使えるんだよなあ。リアルタイムのライン追従? ああ、それも全然いける。でも実際は一回落としたことあるし…まあ関係ないか。本筋戻そう。「MicroPython」と「OpenMV IDE」の二つ――これがライブラリ。

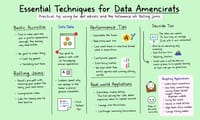

## 4. A*およびRRTによる自律経路計画

🧠 問題点…これは正直、考えるほど泥沼なんだよな。「ロボットが現在位置と目的地を知っていたとして、本当に大事なのはどうやったら崖から落っこちたりペット轢いたりせずにゴールへ行けるか」って、その部分だと思う。たぶんね。でも時々、自分の部屋でも物につまずくし…。――ま、いいか。注意事項書いてても、大事なのはそこじゃない気がしてきたぞ。

import sensor, image, timesensor.reset()

sensor.set_pixformat(sensor.RGB565)

sensor.set_framesize(sensor.QVGA)

sensor.skip_frames(time = 2000)

while(True):

img = sensor.snapshot()

blobs = img.find_blobs([(30, 100, 15, 127, 15, 127)]) # …赤色かも。

for blob in blobs:

img.draw_rectangle(blob.rect())

なんというか、このOpenMVボードってさ、<100msのレイテンシーでビジョンタスク実行できちゃうらしい。ミニドローンにも使えるんだよなあ。リアルタイムのライン追従? ああ、それも全然いける。でも実際は一回落としたことあるし…まあ関係ないか。本筋戻そう。「MicroPython」と「OpenMV IDE」の二つ――これがライブラリ。

## 4. A*およびRRTによる自律経路計画

🧠 問題点…これは正直、考えるほど泥沼なんだよな。「ロボットが現在位置と目的地を知っていたとして、本当に大事なのはどうやったら崖から落っこちたりペット轢いたりせずにゴールへ行けるか」って、その部分だと思う。たぶんね。でも時々、自分の部屋でも物につまずくし…。――ま、いいか。注意事項書いてても、大事なのはそこじゃない気がしてきたぞ。

5. 道なき道でも行けるのか…経路計画アルゴリズムの罠

A*とかRRT(Rapidly-Exploring Random Trees)みたいな古き良き動作計画アルゴリズム、Pythonでも使えるんだよね。えっと、まずは2Dのグリッドマップでお試ししてみるといいかも。なんとなく手軽だし…。まあ、その後に`matplotlib`や`shapely`あたりを組み合わせていけば、実際の環境向けにも拡張できるっぽい。でさ、途中ちょっと脇道だけど…こういう基礎的なアルゴリズムって退屈そうに見えるけど、ちゃんと土台になるから無視できないよな、と今さら思う。——うーん、本題戻すね。

> _🚗_ ファクト:_オリジナルのDARPA Grand Challenge車両ってさ、A*やダイクストラ法のバリエーションをがっつり使ってたらしい。その伝統というか遺産みたいなの、今でもPythonプロトタイプ経由で学習目的とか教育用途には意外と有効なんだって。ほんとかな?_ **ライブラリー:** `numpy`, `matplotlib`, `shapely`, `heapq`

ま、いいか。

python

# 2Dグリッド用の簡単なA*

def a_star(start, goal, grid):

# オープンリストとかコストマップ、それにヒューリスティクスもろもろ…

return path> _🚗_ ファクト:_オリジナルのDARPA Grand Challenge車両ってさ、A*やダイクストラ法のバリエーションをがっつり使ってたらしい。その伝統というか遺産みたいなの、今でもPythonプロトタイプ経由で学習目的とか教育用途には意外と有効なんだって。ほんとかな?_ **ライブラリー:** `numpy`, `matplotlib`, `shapely`, `heapq`

ま、いいか。

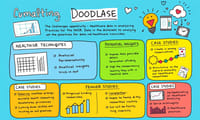

6. ロボットに話しかけてみたら意味通じる?HRIは甘くない

## 5. 人間とロボットの対話型インターフェースによる相互作用

**🧠 課題:** ロボットが重い物を持ち上げられるとしても、「コーヒーを取ってきて、階段は避けて」という指示に対応できるだろうか?うーん、やっぱり言語って難しい。なんか一見簡単そうだけど、実際にロボットに頼んでみると全然意図が伝わらないこともあるし…。いや、本当に階段回避できるのかな、とふと思ったりして。たぶん今の技術じゃ完璧には遠い、気がする。

**💡 Pythonによる解決法:** `transformers` や `sentence-transformers` を使って、人間からの自然言語命令をロボット動作へ変換する技術がある。まあ…便利そうには聞こえるけど、実はそうでもなくて誤認識もしょっちゅう起きたりするよね。人間とロボットとのインタラクション(HRI)の基盤となる大事な仕組みだけど、それだけで全部うまくいくとは限らない。でも希望は感じる。

command = "Pick up the red object near the box"

embedding = model.encode(command)

# 埋め込みベクトルをロボットの行動セットと照合する

> _🗣️_ ファクト: _Boston Dynamicsでは、犬型ロボットのコマンドレイヤーにNLPモデルが統合されており、より自然なやり取りが実現されているという事例がある。_ああ、Boston Dynamicsとかすごいよね。でも自分の家にいたら落ち着かないかも…。

**ライブラリ:** `transformers`, `sentence-transformers`, `nltk`

## 6. ROS2 + Pythonノードによる分散型ロボティクス

**🧠 課題:** ロボットは単一構成体ではない。いやむしろ、それぞれ別々に動いている小さな部品やノードの集まりなんだよね。でも時々、全部ひとつの塊みたいなイメージで語っちゃう人もいるけど…。本当は複雑だし、不安定になったり通信遅延したり面倒ごとも多い。それでもROS2のおかげで連携しやすくなった部分もあるので―まあ進歩はしてると思う。

**🧠 課題:** ロボットが重い物を持ち上げられるとしても、「コーヒーを取ってきて、階段は避けて」という指示に対応できるだろうか?うーん、やっぱり言語って難しい。なんか一見簡単そうだけど、実際にロボットに頼んでみると全然意図が伝わらないこともあるし…。いや、本当に階段回避できるのかな、とふと思ったりして。たぶん今の技術じゃ完璧には遠い、気がする。

**💡 Pythonによる解決法:** `transformers` や `sentence-transformers` を使って、人間からの自然言語命令をロボット動作へ変換する技術がある。まあ…便利そうには聞こえるけど、実はそうでもなくて誤認識もしょっちゅう起きたりするよね。人間とロボットとのインタラクション(HRI)の基盤となる大事な仕組みだけど、それだけで全部うまくいくとは限らない。でも希望は感じる。

makefile

from sentence_transformers import SentenceTransformer

model = SentenceTransformer("all-MiniLM-L6-v2")command = "Pick up the red object near the box"

embedding = model.encode(command)

# 埋め込みベクトルをロボットの行動セットと照合する

> _🗣️_ ファクト: _Boston Dynamicsでは、犬型ロボットのコマンドレイヤーにNLPモデルが統合されており、より自然なやり取りが実現されているという事例がある。_ああ、Boston Dynamicsとかすごいよね。でも自分の家にいたら落ち着かないかも…。

**ライブラリ:** `transformers`, `sentence-transformers`, `nltk`

## 6. ROS2 + Pythonノードによる分散型ロボティクス

**🧠 課題:** ロボットは単一構成体ではない。いやむしろ、それぞれ別々に動いている小さな部品やノードの集まりなんだよね。でも時々、全部ひとつの塊みたいなイメージで語っちゃう人もいるけど…。本当は複雑だし、不安定になったり通信遅延したり面倒ごとも多い。それでもROS2のおかげで連携しやすくなった部分もあるので―まあ進歩はしてると思う。

7. ROS2で分裂ロボ、部品同士のおしゃべりバトル勃発

それらってさ、結局システムがごちゃっと集まった塊みたいなもので。うーん、センサーとかアクチュエータ、それにプランナーやコントローラーなんかが、わざわざお互いに通信しないと何も始まらない。えっと……まあ、あの複雑さをどう扱えばいいのかって頭抱えるけど、Pythonでなら案外なんとかなる気もしなくはない。途中で「いやこれ違うな」と思ったりもしたけど──話戻して、とりあえず**💡 Pythonによる解決策:** 分散型通信を支えるために `rclpy` 使ってROS2ノードを書いてみるのが手っ取り早い。その上で各モジュールがロボティクススタック内で再利用可能なサービスとして動くよう設計できるし…たぶんね。

rclpy.init()

node = MinimalPublisher()

rclpy.spin(node)

> _🤖 F_act: _NASAが最近飛ばしている自律型ドローンでもROS2は使われていてさ、その制御ロジックの中核にはPythonベースのノードが大活躍しているんだとか。ほんとかな…。

> **ライブラリ:** `rclpy`, `std_msgs`, `geometry_msgs`, `sensor_msgs`

## 7. Pythonと機械学習による自己診断ロボット

**🧠 課題:** ミッション中に万一トラブル起きたら?普通はロボットその場で黙り込むしかない。でも、一部では自己診断や復旧機能まで備えてたりするから驚くよね。いや、「そんな都合よくいく?」と疑いたくなるけど、実際そういう事例もちらほらあるし。

python

import rclpy

from rclpy.node import Node

python

class MinimalPublisher(Node):

def __init__(self):

super().__init__('publisher_node')

# publisher setup...rclpy.init()

node = MinimalPublisher()

rclpy.spin(node)

> _🤖 F_act: _NASAが最近飛ばしている自律型ドローンでもROS2は使われていてさ、その制御ロジックの中核にはPythonベースのノードが大活躍しているんだとか。ほんとかな…。

> **ライブラリ:** `rclpy`, `std_msgs`, `geometry_msgs`, `sensor_msgs`

## 7. Pythonと機械学習による自己診断ロボット

**🧠 課題:** ミッション中に万一トラブル起きたら?普通はロボットその場で黙り込むしかない。でも、一部では自己診断や復旧機能まで備えてたりするから驚くよね。いや、「そんな都合よくいく?」と疑いたくなるけど、実際そういう事例もちらほらあるし。

8. 壊れても止まらない夢。異常検知が救う現場

**💡 Pythonによるソリューション:**

異常検知といえば、無監督学習——たとえばIsolation Forestやオートエンコーダーみたいなものを使って、テレメトリーの監視をやるわけだけど。えっとね、これによって故障が広がる前に発見できたりするんだよね。でも…実際、完全に防げるかは怪しいし。ああ、うまくいく時もある。

from sklearn.ensemble import IsolationForest

model = IsolationForest(contamination=0.1)

model.fit(sensor_data)

# 新しい計測値が異常かどうかを予測

is_faulty = model.predict(new_data)

> _🩺 F_act:_ ABBとかFanucの産業用ロボットアーム――まあ有名だよな――にはさ、この手の異常検知モデルでヘルスチェックする機能が実装されているらしい、と何度も耳にした。で、多くの場合Pythonで試作しているという話も転がっていたりして…。いや、本当にそうなのかなと思ったけど。

**ライブラリ:** `sklearn`, `pandas`, `numpy`, `matplotlib`

## それから――ロボットは「そのうち来る」と思われがちだけど、もう既にそこにいて当たり前という感じにもなる。不思議だよね、Pythonは今やロボットの考えるプロセスにも溶け込んでいる。ま、それも悪くないかもしれない…多分。

異常検知といえば、無監督学習——たとえばIsolation Forestやオートエンコーダーみたいなものを使って、テレメトリーの監視をやるわけだけど。えっとね、これによって故障が広がる前に発見できたりするんだよね。でも…実際、完全に防げるかは怪しいし。ああ、うまくいく時もある。

from sklearn.ensemble import IsolationForest

model = IsolationForest(contamination=0.1)

model.fit(sensor_data)

# 新しい計測値が異常かどうかを予測

is_faulty = model.predict(new_data)

> _🩺 F_act:_ ABBとかFanucの産業用ロボットアーム――まあ有名だよな――にはさ、この手の異常検知モデルでヘルスチェックする機能が実装されているらしい、と何度も耳にした。で、多くの場合Pythonで試作しているという話も転がっていたりして…。いや、本当にそうなのかなと思ったけど。

**ライブラリ:** `sklearn`, `pandas`, `numpy`, `matplotlib`

## それから――ロボットは「そのうち来る」と思われがちだけど、もう既にそこにいて当たり前という感じにもなる。不思議だよね、Pythonは今やロボットの考えるプロセスにも溶け込んでいる。ま、それも悪くないかもしれない…多分。

9. Pythonの知られざる現場力と地味な武器たち

それが結局、彼らの成長にちゃんと寄与しているんだと思う――安全で、うーん…賢く、しかも規模を拡大しながら。いや、本当にそうなのか自分でも時々疑いたくなるけど。でも倉庫用ロボットの試作だったり、水中ドローンの微妙な調整に挑むときもね、不思議なくらいPythonの素直な記述のおかげで頭のリソースが論理組み立てだけに向けやすい。書かなきゃいけない面倒な部分が減るからさ、ま、ありがたいことだよ。

それでいて、この週末には…えっと、一つだけワークフローを選んで構築してみたらどうかなって思ったりした。突然話逸れるけど、自分は毎回迷って選べないタイプ。でも戻るとね、それを実際やってみてほしいという提案なんだ。なんせPythonコードを書いて、自分の手元で何か物理的に動く瞬間を見る体験――これはロボティクスに足踏み入れる最初の火種になる可能性が高いし。本当に、未来を創る許可なんて誰にも要らないから、とりあえず自動化へ手を出してみてほしい……たぶん、それだけでも十分意味がある気がする。

それでいて、この週末には…えっと、一つだけワークフローを選んで構築してみたらどうかなって思ったりした。突然話逸れるけど、自分は毎回迷って選べないタイプ。でも戻るとね、それを実際やってみてほしいという提案なんだ。なんせPythonコードを書いて、自分の手元で何か物理的に動く瞬間を見る体験――これはロボティクスに足踏み入れる最初の火種になる可能性が高いし。本当に、未来を創る許可なんて誰にも要らないから、とりあえず自動化へ手を出してみてほしい……たぶん、それだけでも十分意味がある気がする。

10. 最後に:未来は黙ってやって来るものじゃない

もしロボティクスにまつわる話やちょっとしたアイディアがあれば、まあ、気軽にコメント欄で教えてもらえるとうれしいな。なんだかんだ言って、一緒にもっと面白いモノを作りたい、そんな気持ちがあるんだけど…あ、今は眠いけどさ 🤖🐍

## コミュニティの一員でいてくれて本当にありがとう

_帰る前に:_

- もし良ければライターを**拍手**してくれたり、**フォロー**とかしてみてもいいかも?いや、別に強制じゃないけど ️👏 ️**️**

- フォロー先は一応書いとくね:**X** | **LinkedIn** | **YouTube** | **Newsletter** | **Podcast** | **Twitch**

- あー、それから…実はね、**Differでは無料でAI付きブログ始められるんだってさ。知ってた?** 🚀

- さらに言うと…うーん、なんかよくわからないけど、とりあえずDiscordのクリエイターコミュニティにも参加できるらしい 🧑🏻💻

- 詳しいことはさ、まあ時間がある時にでも、**plainenglish.io** とか **stackademic.com** 覗いてみてほしいな。自分もまだ全部チェックしきれてないし…。