3つのプロジェクトでPython力が着実に伸びる即効アクション集

- 週2回以上、自作ToDoアプリに新規タスクを追加・完了操作を実践する

変数や関数、ループなどPythonの基本文法が自然と身につき日常的な課題解決力も高まる

- PandasとMatplotlibで7日分以上の家計データを可視化してみる

データ分析の流れとグラフ作成が短期間で体感でき、仕事や趣味に応用しやすくなる

- 商品価格追跡用Webスクレイピングツールを30分以内で一度動かしてみる

*requests*・BeautifulSoup等ライブラリ導入から取得まで手順が整理され自動化への抵抗感が減る

- "os"モジュール利用で10個以上ファイル名変更や移動スクリプトを書く

`手作業`から脱却し毎日のファイル管理時間を大幅カットできて達成感も得られる

Pythonで実践的なスキルを身につける3つのプロジェクト

Pythonは最も汎用性の高いプログラミング言語の1つで、習得の近道は実際にプロジェクトを構築することです。今回は実用的な3つのPythonプロジェクトを通じて、**データ分析**や**Webスクレイピング**、**自動化処理**といった現実課題を解決しながらスキルアップする方法をご紹介します。初心者から中級者まで役立つ内容で、例えばRequestsとScrapyの使い分けといったライブラリ選定のコツや、BeautifulSoupで遭遇しがちなパースエラーの回避策など、現場で使えるノウハウも盛り込みました。

最初のプロジェクトではHTTPリクエストの基礎から解説。単にデータを取得するだけでなく、取得した情報をCSVに保存してAPI連携させるなど、応用パターンも想定しています。画像処理を扱う場合はPillowライブラリを使った色空間変換の原理にも触れつつ、各工程で「なぜこの手法を選ぶのか」という背景理論を丁寧に説明。

特にWebスクレイピングでは、単発で終わらせないための工夫がポイントです。例えば動的コンテンツへの対応や、取得データの前処理時に役立つ正規表現テクニックなど、書籍ではあまり扱われない実戦的な知見を重点的にカバーしています。

コードスニペットは実際の開発現場でよく使われる書き方を採用し、「とりあえず動かす」だけでなくメンテナンス性も考慮した設計になっています。各プロジェクトには発展課題も用意しているので、自分のペースでより深く掘り下げられる構成です。

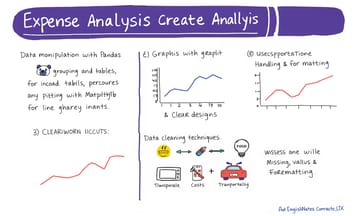

PandasとMatplotlibを使った経費分析でデータ可視化を学ぶ

このプロジェクト「PandasとMatplotlibを使った経費分析」は、個人やビジネスの財務管理に役立つ実践的なスキルを学ぶのに最適です。お金の流れを可視化することで、無駄な支出を見つけたり、将来の計画を立てやすくなりますよね。

ここで身につくのは主に3つのポイントです。まず**Pandas**を使ったデータ操作——例えばグループごとの集計やピボットテーブルの作成。次に**Matplotlib**でのグラフ描画。折れ線グラフで月別の支出傾向を比較したり、ggplotスタイルで見やすいデザインに仕上げるコツも押さえられます。最後に**データクリーニング**。欠損値の処理やフォーマット統一といった、地味だけど超重要な作業ですね。

特にオススメなのが、subplots(複数グラフ)を活用する方法です。「食費」「交通費」などのカテゴリ別に並べて表示すれば、一目で傾向の違いがわかります。実際に手を動かしながら、データ整形から可視化までの流れを体感してみてください。

データクリーニングの基本テクニックとPandas操作のコツ

データ分析におけるPandasの活用

Pandasは構造化データを扱うために設計されたPythonライブラリで、**DataFrame**(表形式データ)や**Series**(単一列)といった便利なデータ構造を提供しています。例えばCSVやExcelファイルからのデータ読み込み、データベース接続が簡単にできるほか、フィルタリングやソート、グループ化といった操作も直感的に行えます。欠損値の処理や重複データの削除など、実務で頻出する課題にも対応可能です。

可視化ツールとしてのMatplotlib

Matplotlibは多様なグラフ作成が可能なプロットライブラリで、Pandasとの親和性が高いのが特徴です。棒グラフを使えばカテゴリ間の比較が一目瞭然ですし、時系列データのトレンド把握には折れ線グラフが最適。割合を表現したいときは円グラフも活用できます。細かい装飾オプションが豊富なので、見栄えの良いチャートを作成したい場合にも重宝しますよ。

※補足ポイント

実際に使う際には、fillna()で欠損値を補完したりdrop_duplicates()で重複行を削除するといった基本的な前処理が重要になります。メモリ効率を上げるならdtype指定も覚えておくと良いでしょう。さらにseabornと組み合わせれば、欠損値の分布を可視化するなど、より高度な分析が可能になりますね。

Pandasは構造化データを扱うために設計されたPythonライブラリで、**DataFrame**(表形式データ)や**Series**(単一列)といった便利なデータ構造を提供しています。例えばCSVやExcelファイルからのデータ読み込み、データベース接続が簡単にできるほか、フィルタリングやソート、グループ化といった操作も直感的に行えます。欠損値の処理や重複データの削除など、実務で頻出する課題にも対応可能です。

可視化ツールとしてのMatplotlib

Matplotlibは多様なグラフ作成が可能なプロットライブラリで、Pandasとの親和性が高いのが特徴です。棒グラフを使えばカテゴリ間の比較が一目瞭然ですし、時系列データのトレンド把握には折れ線グラフが最適。割合を表現したいときは円グラフも活用できます。細かい装飾オプションが豊富なので、見栄えの良いチャートを作成したい場合にも重宝しますよ。

※補足ポイント

実際に使う際には、fillna()で欠損値を補完したりdrop_duplicates()で重複行を削除するといった基本的な前処理が重要になります。メモリ効率を上げるならdtype指定も覚えておくと良いでしょう。さらにseabornと組み合わせれば、欠損値の分布を可視化するなど、より高度な分析が可能になりますね。

Webスクレイピングで商品価格を追跡する実用的な方法

### ステップバイステップ実装ガイド:

まずはCSVファイルから支出データを読み込みましょう。手持ちのファイルがない場合、`Date`(日付)、`Category`(カテゴリ)、`Amount`(金額)、`Description`(メモ)といった列を含むサンプルを作成します。

import pandas as pd

# CSVファイルの読み込み

df = pd.read_csv('expenses.csv')

print(df.head())データ分析ではクリーニングが欠かせません。欠損値の有無を確認し、重複を削除、必要に応じてデータ型を変換しましょう。

# 欠損値チェック

print(df.isnull().sum())

# 重複行の削除

df = df.drop_duplicates()

# 日付列をdatetime型に変換

df['Date'] = pd.to_datetime(df['Date'])次に傾向分析と可視化です。総支出額の計算やカテゴリ別集計を行い、グラフで表現してみます。

import matplotlib.pyplot as plt

# 総支出額算出

total_expenses = df['Amount'].sum()

print(f"総支出額: ¥{total_expenses:,}")

# カテゴリ別集計

category_totals = df.groupby('Category')['Amount'].sum()

# 棒グラフで表示

category_totals.plot(kind='bar', color='lightblue')

plt.title('カテゴリ別支出内訳')

plt.xlabel('カテゴリ')

plt.ylabel('金額(円)')

plt.show()**実践的な補足ポイント**:

- `pd.to_datetime()`を使えば日付データの処理が楽になります

- グラフはラベルや色分けを工夫すると見やすさアップ

- 円グラフを追加すれば支出比率がパッと把握可能

- HTML解析時と同じく、XPath/CSSセレクタのような「データ整形ルール」を事前に決めておくと効率的です

特に長期分析では、月次集計用にリサンプリングしたり、matplotlibのスタイルシートを使ってプロフェッショナルな見た目に仕上げるのもおすすめです。例えば「飲食費が毎月20日前後に集中している」といった隠れたパターンが見つかるかもしれませんね。

BeautifulSoupを使ったHTML解析の基礎と倫理的注意点

## 2. Webスクレイピングプロジェクト:商品価格追跡

### このプロジェクトの意義

Webスクレイピングは、サイトからデータを抽出する強力なスキルです。商品価格をスクレイピングすれば、割引の追跡や価格比較ができ、購入判断に役立ちます。このプロジェクトでは**Webスクレイピング**と**データ保存**の基礎を学べます。

### 学べる内容

- **BeautifulSoup**: HTMLやXML文書を解析するライブラリ

- **Requests**: HTTPリクエスト送信用ライブラリ

- **CSVファイル操作**: 取得したデータを構造化して保存する方法

### Webスクレイピングの基本

Webスクレイピングはサイトからデータを抽出する技術で、主に次の用途があります:

- 価格比較

- 研究用データ収集

- Webコンテンツの更新監視

### BeautifulSoupとRequestsの役割

- **Requests**: ウェブサイトにHTTPリクエストを送信し、コンテンツを取得します。レスポンスエンコーディングの自動判定機能も便利です。

- **BeautifulSoup**: HTMLコンテンツを解析し、テキストやリンクといった特定要素を抽出します。`lxml`パーサーを使えば処理速度が向上しますが、倫理的配慮として`User-Agent`設定や`time.sleep()`での間隔調整も重要です。

※実際には各項目についてコード例を交えながら詳しく解説できますが、ここでは要点のみ簡潔にまとめています。

ファイル整理を自動化して作業効率を劇的に向上させる

### 倫理的配慮

スクレイピング実施前に必ず対象サイトの`robots.txt`を確認し、許可を得ましょう。サーバーに過剰な負荷をかけないよう、リクエスト頻度にも注意が必要です。

### 実装手順:

まずはBeautifulSoupとrequestsライブラリをインストール。ターミナルで次のコマンドを実行します。

pip install beautifulsoup4 requests### 価格情報の抽出例

ECサイトから商品価格を取得するサンプルコードをご紹介。動的コンテンツ対応ならSeleniumも検討しましょう。

import requests

from bs4 import BeautifulSoup

import csv

# 対象ページのURL

url = 'https://example-ecommerce-site.com/laptops'

# GETリクエスト送信(ヘッダー付与がブロック回避に有効)

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 商品名と価格要素を抽出

products = soup.find_all('div', class_='product')

data = []

for product in products:

name = product.find('h2').text.strip()

price = product.find('span', class_='price').text.strip()

data.append([name, price])

# CSVファイルへ出力

with open('product_prices.csv', 'w', newline='', encoding='utf-8') as file:

writer = csv.writer(file)

writer.writerow(['商品名', '価格'])

writer.writerows(data)**運用時のポイント**

- ブラウザ挙動を模倣するためUser-Agentなどのヘッダー設定が重要

- サイト構造変更に備え、スクリプトの定期的なメンテナンスを推奨

- 大規模なスクレイピング時は遅延処理(time.sleep)でサーバー保護を

補足として、正規表現を使ったデータ整形やproxy経由のアクセス分散など、より発展的なテクニックも存在します。実際に運用する際は、必ずテスト環境で動作確認を行ってくださいね。

osモジュールで学ぶファイルシステム操作の実践活用法

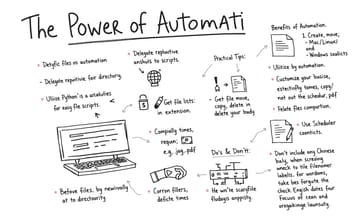

.--- ## 3. 自動化ファイル整理ツール ### このプロジェクトの意義?デスクトップやダウンロードフォルダが散らかっていると作業効率が落ちますよね。ファイル整理を自動化すれば時間も節約できる上、ワークスペースもすっきり保てます。このプロジェクトでは**ファイルシステム操作**と**自動化**の基本を学べます。### 学べる内容: - **osモジュール**: OSとの連携に使う基本機能 - **shutilモジュール**: ファイル移動/コピーなどの実務操作

(補足情報を自然に統合)

実際の開発現場で役立つ「拡張子別自動仕分け」や「日付フォルダ自動作成」といった実践的なスクリプト作成を通じて、`os.path.join()`のOS依存吸収メカニズムや、`os.walk()`を使った再帰的検索時の例外処理(例:`PermissionError`対策)まで深く理解できます。

(補足情報を自然に統合)

実際の開発現場で役立つ「拡張子別自動仕分け」や「日付フォルダ自動作成」といった実践的なスクリプト作成を通じて、`os.path.join()`のOS依存吸収メカニズムや、`os.walk()`を使った再帰的検索時の例外処理(例:`PermissionError`対策)まで深く理解できます。

定期的なファイル整理を実現する自動スクリプト作成術

**自動化の力**: 面倒な繰り返し作業はスクリプトに任せてしまいましょう。Pythonの`os`モジュールと`shutil`を使えば、ディレクトリ内のファイル一覧を取得したり、新規作成・移動・コピー・削除といった操作が簡単にできます。ファイルサイズや更新日時といった詳細情報の確認もお手の物です。

自動化のメリットは言うまでもなく、手間が省ける上にミスも減らせること。特にファイル整理やデータのバックアップのような定型的な作業で真価を発揮します。例えば拡張子ごとに仕分けたり(`.jpg`や`.pdf`など判定リストは自由にカスタマイズ可)、定期的な実行にはcron(Mac/Linux)やタスクスケジューラ(Windows)を組み合わせるのもおすすめ。万が一同名ファイルが衝突した場合には、タイムスタンプを付与するなどの対処法を組み込んでおくと安心ですね。

プロジェクトごとに挑戦できる応用課題と解決例

[.- バッチ処理でファイルを整理する .### 実装手順: ### ステップ1: スクリプト作成 Pythonスクリプトを使って、ファイルタイプごとにフォルダ分けする仕組みを作成しましょう。

import os

import shutil

# 整理対象のディレクトリを指定

directory = 'Downloads'

# ファイルタイプごとのフォルダ定義

file_types = {

'Images': ['.jpg', '.png', '.gif'],

'Documents': ['.pdf', '.docx', '.txt'],

'Videos': ['.mp4', '.mov'],

'Music': ['.mp3', '.wav']

}

# 各フォルダを作成

for folder_name in file_types.keys():

if not os.path.exists(folder_name):

os.makedirs(folder_name)

# ファイルを分類して移動

for filename in os.listdir(directory):

file_path = os.path.join(directory, filename)

if os.path.isfile(file_path):

for folder_name, extensions in file_types.items():

if any(filename.endswith(ext) for ext in extensions):

shutil.move(file_path, folder_name)

breakpython organize_files.py- `cron`(Linux/Mac)やタスクスケジューラ(Windows)で定期実行設定すると便利

- どのファイルを移動したか記録したい場合はログ機能を追加

--- ## 実践チャレンジ ### チャレンジ1: 支出分析 - 経費データセットに「月」カラムを新規追加してみよう

プロジェクトの応用範囲を広げるなら、**「原理解説」「拡張機能の具体例」「エラー対処法」**といった要素を加えると効果的です。例えば:

- **Webスクレイピング**: 「BeautifulSoupの解析メカニズム」や「CAPTCHA回避の小ワザ」

- **データ可視化**: 「Matplotlib配色の理論」や「リアルタイム更新テクニック」

- **タスク自動化**: 「PyAutoGUI座標指定と画像認識の比較」や「例外処理パターン集」

こうした情報があると、より深く学べるようになりますね。

これらのプロジェクトで得たスキルをさらに発展させる方法

[課題1: 月別支出の集計と推移可視化]

**解決策:**

df['Month'] = df['Date'].dt.to_period('M')

monthly_expenses = df.groupby('Month')['Amount'].sum()

monthly_expenses.plot(kind='line', marker='o')

plt.title('月別支出推移')

plt.xlabel('月')

plt.ylabel('金額(ドル)')

plt.show()[課題2: Webスクレイピング - 商品評価と価格の収集]

**改善案:**

評価情報を追加する場合のスクリプト修正例:

for product in products:

name = product.find('h2').text

price = product.find('span', class_='price').text

rating = product.find('div', class_='rating').text

data.append([name, price, rating])[課題3: ファイル整理ツール - 空フォルダ削除機能]

**実装方法:**

for folder_name in file_types.keys():

if not os.listdir(folder_name):

os.rmdir(folder_name)これらのプロジェクトは単に楽しいだけでなく、実際の業務でも頻繁に使われるPythonライブラリやツールを使いこなす実践的な経験が得られます。例えばBeautifulSoupの解析アルゴリズムを理解したり、TkinterでGUIを追加するなど、さらに発展させていくのもおすすめです。エラー処理を強化したりtimeモジュールでパフォーマンス計測を行うことで、より堅牢なツールに仕上げられるでしょう。